ChatGPT 的横空出世与 DeepSeek 的迅速崛起,将人工智能再次推至科技浪潮之巅。科技公司、企业与创业者纷纷入局,不仅仅是想要抓住技术的红利,也有出于被时代淘汰的担忧。全民 AI 时代随之到来,大模型成为热门话题。

然而,当我们在谈论 AI 时,可能互相谈论的不是同一个东西。在互联网碎片化信息和媒体过度营销的影响下,不少人对 AI 产生认知偏差,认为:AI 就是 ChatGPT、AI 就是 DeepSeek,AI 应用就是提示词工程,AI 是新的科技革命,AI 现在无所不能,只要接入 AI 马上就可以替代员工从而降本增效……但事实上,ChatGPT 和 DeepSeek 只是大语言模型技术的两个应用产品,AI 的领域也远不止文本处理、推理和生成,提示词只是目前与文本类 AI 最有效的交流方式,AI 的研究在上个世纪就开始了,大模型很强大但也有它的缺陷,完全替代人为时尚早。过度营销也是一种营销策略,它可以制造认知泡沫,培养行业“韭菜”,然后在你懵懵懂懂但又想分一杯羹的时候收割一把。

我在探索 AI 过程中强烈意识到,要想应用好大模型技术,必须先从底层全面了解它是什么,怎么来的,底层依赖哪些技术,能做什么,不能做什么,当前主流大模型产品在 AI 应用领域处于什么位置。否则只会在层出不穷的大模型产品中迷失方向,沦为行业“韭菜”。于是花了一些时间翻查资料,整理后有了本文。本文可以帮助你了解到底什么是大语言模型,什么是大模型,什么是 AI,它们之间到底是什么关系,人工智能到底在研究什么,AI 背后依赖哪些技术,了解这些有助于你厘清概念、消除误解、和警惕幻觉,进一步戳破认知泡沫、有的放矢地去探索大模型应用的边界、更好地应用好大模型工具去创造价值。

PS: 如有错漏之处请留言告诉我 :)

一、AI

什么是 AI

AI:Artificial Intelligence,人工智能。人工智能是一个广泛的研究领域,旨在使机器能够模拟人类的智能行为,包括学习、推理、解决问题、感知环境、语言理解和生成等。

AI 核心研究领域

1. 机器学习(Machine Learning)

目标:让计算机从数据中自动学习规律,实现预测或决策。

分支:

- 监督学习(如分类、回归,应用于图像识别、垃圾邮件过滤)。

- 无监督学习(如聚类、降维,用于数据挖掘、用户分群)。

- 强化学习(通过奖励机制优化行为,应用于机器人控制、游戏 AI、自动驾驶)。

关键技术:深度学习(Deep Learning,如卷积神经网络 CNN、循环神经网络 RNN)、生成对抗网络(GAN)、迁移学习等。

2. 自然语言处理(NLP, Natural Language Processing)

目标:实现人机间自然语言的理解与交互。

研究方向:

- 语言理解:分词、句法分析、语义角色标注。

- 语言生成:机器翻译、文本摘要、对话系统(如 ChatGPT)。

- 应用场景:智能客服、机器翻译、情感分析、知识图谱构建。

3. 计算机视觉(CV, Computer Vision)

目标:使计算机具备 “看” 和理解图像 / 视频的能力。

核心任务:

- 图像分类(如 ResNet 模型识别物体)。

- 目标检测与分割(YOLO 系列、Mask R-CNN)。

- 视频理解(动作识别、视频生成,如 Stable Diffusion)。

应用:自动驾驶、医学影像诊断、安防监控、AR/VR。

4. 机器人学(Robotics)

目标:设计具备感知、决策和执行能力的智能机器人。

分支:

- 感知机器人:通过传感器(视觉、触觉)感知环境(如波士顿动力机器人)。

- 自主机器人:路径规划、SLAM(同步定位与地图构建)、多机器人协作。

- 交叉领域:人机交互、仿生机器人、医疗机器人。

5. 知识表示与推理(Knowledge Representation and Reasoning)

目标:将人类知识结构化,支持机器推理和决策。

方法:

- 逻辑表示(如一阶谓词逻辑、描述逻辑)。

- 语义网络与知识图谱(如 Google 知识图谱、医疗知识图谱)。

应用:专家系统(如医疗诊断系统)、自动定理证明、常识推理。

6. 伦理与社会影响(AI Ethics and Society)

目标:研究 AI 的社会、法律和伦理问题,确保技术可控。

核心议题:

- 公平性:算法偏见(如招聘歧视、人脸识别偏差)。

- 可解释性(XAI):深度学习模型的透明性与可解释性。

- 隐私保护:数据安全与合规(如 GDPR 对 AI 的影响)。

- 就业与经济影响:自动化对劳动力市场的冲击与转型。

AI 三大流派

1. 符号主义(Symbolism)

又称逻辑主义、心理学派或计算机学派,认为人工智能源于数理逻辑。其基本假设是物理符号系统假设,即人类认知和思维的基本单元是符号,认知过程是符号运算。符号主义奠定了人工智能基于逻辑推理的基础,在早期取得了显著成果,但在处理常识和不确定性问题上遇到困难。

2. 连接主义(Connectionism)

核心思想是通过模拟生物神经网络的结构和工作机制来实现智能。从仿生学角度出发,通过对神经网络的研究实现了深度学习的突破,在众多领域展现出强大的能力。连接主义认为,智能的本质是分布式信息处理和自适应学习,而非符号主义(Symbolism)所强调的规则逻辑或行为主义(Behaviorism)的刺激 - 反应模式。

3. 行为主义(Symbolism)

行为主义认为人工智能可以用控制论的理论基础进行实现。其思想根源可以追溯到早期对动物和人类行为的研究,强调智能体与环境的交互作用。控制论的发展为行为主义提供了理论支持,使得研究者们开始从行为控制的角度探索人工智能的实现方式。 在机器人领域,行为主义得到了广泛应用。

表1

| 学派 | 核心假设 | 代表技术 | 典型应用 |

|---|---|---|---|

| 符号主义 | 智能源于逻辑推理与符号系统 | 专家系统、逻辑编程 | 知识图谱、定理证明 |

| 连接主义 | 智能源于神经网络的连接机制 | 深度学习、神经网络 | 图像识别、自然语言处理 |

| 行为主义 | 智能源于自适应行为与环境交互 | 强化学习、进化算法 | 机器人控制、游戏 AI(如 AlphaGo) |

AI 发展历程

1、孕育期(1940s-1956 年):从数理逻辑到智能设想

核心特征:理论奠基与思想萌芽

- 1936 年,图灵提出 “图灵机” 模型,奠定计算机可计算性理论基础;1943 年,McCulloch 和 Pitts 提出人工神经元模型,模拟生物神经网络的逻辑单元。

- 1948 年,维纳《控制论》提出 “机器与生物的信息处理共性”,为智能系统提供哲学启发。

- 1950 年,图灵发表《计算机器与智能》,提出 “图灵测试”,成为判断机器智能的标准;同年,香农设计国际象棋程序,开启机器博弈研究。

- 1955 年,纽厄尔和西蒙开发 “逻辑理论家”(LT)程序,证明《数学原理》中的 38 条定理,首次展现符号系统的推理能力。

2、诞生与黄金年代(1956-1974 年):符号主义主导的乐观主义

1956 年,达特茅斯会议,麦卡锡、明斯基等学者首次提出 “人工智能” 术语,确立研究目标:用机器模拟人类学习、推理和问题解决能力。美国国防部高级研究计划局(DARPA)等机构大幅资助,公众期待 “20 年内机器能完成人类所有智力工作”,但忽视了复杂问题(如常识推理、自然语言理解)的难度。

核心特征:学科正式诞生,符号逻辑与专家系统兴起

关键技术方向:

- 符号主义(逻辑学派):认为智能源于符号逻辑推理,代表成果包括:

- 1959 年,塞缪尔开发跳棋程序,通过机器学习超越人类水平。

- 1965 年,鲁宾逊提出归结原理,为自动定理证明奠定基础。

- 1965 年,费根鲍姆开发首个专家系统 DENDRAL(化学质谱分析),标志 “知识工程” 诞生。

- 连接主义(神经网络学派):

- 早期探索受限于计算能力,代表性工作为 1958 年罗森布拉特提出 “感知机”,但 1969 年明斯基《感知机》一书指出其理论局限性,导致该方向陷入停滞。

3、第一次寒冬(1974-1980 年):期望破灭与资金退潮

核心特征:理论瓶颈与产业挫折

- 符号系统在 “常识推理”(如理解 “椅子是用来坐的”)和 “组合爆炸” 问题上举步维艰。

- 神经网络因计算能力不足和理论缺陷(如无法训练多层网络)被边缘化。

- 机器翻译早期成果(如 1954 年 IBM 的英俄翻译演示)暴露语义理解不足,美国政府 1966 年发布《ALPAC 报告》否定机器翻译可行性,导致项目大规模撤资。

- 资金缩减:DARPA 取消对通用问题求解器(GPS)等项目的资助,英国政府 1973 年《莱特希尔报告》批评人工智能 “夸大承诺”,学界进入低潮。

4、专家系统与知识工程复兴(1980-1987 年):符号主义的第二次浪潮

背景:微处理器的进步,计算机性能有所提升

核心特征:限定领域的实用化突破,专家系统商业化

- 1976 年,Shortliffe 开发医疗诊断系统 MYCIN,准确率超人类专家。

- 1980 年,DEC 公司的 XCON 系统用于计算机配置,每年节省数千万美元。

- 日本 1981 年启动 “第五代计算机计划”,目标是开发基于逻辑程序设计的智能计算机,虽未完全成功,但推动了硬件与软件协同发展。

- 知识表示革命:框架理论(Minsky, 1974)、语义网络等技术被用于结构化知识建模,“知识工程师” 成为新兴职业。

- 局限性显现:专家系统依赖人工编码知识,难以扩展至复杂场景,且缺乏学习能力,被批评为 “昂贵的手工制品”。

5、第二次寒冬(1987-1997 年):符号系统的崩塌与统计学习崛起

背景:计算机性能进一步提升,数据量增长

核心特征:符号主义衰退,数据驱动方法悄然兴起

符号系统的困境:

- 1987 年,Lisp 机器市场崩溃(Symbolics 等公司破产),标志符号主义商业路径失败;

- 逻辑 - based 系统(如 Cyc 项目)试图构建人类常识知识库,但工程规模远超预期。

统计学习的曙光:

- 1986 年,Rumelhart 等重新提出反向传播算法(BP 算法),解决多层神经网络训练问题,掀起连接主义复兴。

- 1995 年,Vapnik 提出支持向量机(SVM),在小数据场景下表现优于神经网络,成为机器学习主流。

- 自然语言处理领域,Chomsky 的句法理论遭遇挑战,统计机器翻译(如 IBM 的 Candide 项目)凭借大规模语料库展现实用性。

- 标志性事件:1997 年,IBM 深蓝击败国际象棋世界冠军卡斯帕罗夫,虽依赖暴力搜索而非真正智能,但证明 “有限领域可计算性” 的价值。

6、深度学习革命(1998-2018 年):从感知到认知的跨越

背景:互联网普及,计算机性能大幅提高,大数据算力提升

核心特征:神经网络卷土重来,大数据与算力驱动突破

技术突破:

- 1998 年,LeCun 提出卷积神经网络(CNN),应用于手写数字识别(MNIST 数据集),奠定计算机视觉基础。

- 2006 年,Hinton 提出 “深度信念网络”(DBN),通过逐层预训练解决深层网络优化难题,“深度学习” 成为独立领域。

- 2013 年,Word2Vec(Mikolov)将词语映射为向量空间,开启自然语言处理的分布式表示时代。

- 2017 年,Vaswani 等提出 Transformer 架构,通过自注意力机制解决长序列依赖问题,成为大语言模型的基石。

- 2018 年,BERT(Google)和 GPT(OpenAI)开启预训练模型时代,通用语言理解能力显著提升。

产业爆发:

- 2012 年,AlexNet(Hinton 团队)在 ImageNet 图像识别中准确率远超传统方法,引发视觉领域全面转向深度学习。

- 2016 年,AlphaGo 击败围棋世界冠军李世石,展示强化学习与神经网络的结合威力。

- 2018 年,BERT(Google)和 GPT(OpenAI)开启预训练模型时代,通用语言理解能力显著提升。

7、大模型与通用智能探索(2019 年至今):从专用到通用的跃迁

核心特征:超大规模预训练模型涌现,多模态与具身智能成为新方向

大语言模型(LLM)的统治力:

- 2020 年,GPT-3(1750 亿参数)通过 “少样本学习” 展现通用任务能力,引发 “提示工程” 新范式。

- 2023 年,GPT-4、Claude 2、LLaMA 等模型突破逻辑推理、代码生成、多语言理解等能力,ChatGPT 用户量两个月破亿,标志 AI 进入消费级应用阶段。

- 2025 年,DeepSeek R1 发布,采用 MoE 架构,训练成本仅为 GPT-4 的 1/70,推理成本降低至 1/30,推动 AI 大规模商用。

多模态与具身智能:

- 模型融合文本、图像、语音、视频等多模态数据,如 DALL・E(文本生成图像)、Sora(文本生成视频)。

- 具身智能(Embodied AI)探索机器人与环境互动,如 Google 的 SayCan、DeepMind 的 RoboCat,试图解决 “感知 - 决策 - 行动” 闭环。

社会与伦理挑战:

生成式 AI 引发内容安全(深度伪造)、偏见公平、隐私泄露等争议,各国加速制定 AI 治理政策(如欧盟《AI 法案》)。

螺旋上升的智能进化史

人工智能的发展始终遵循 “期望 - 泡沫 - 低谷 - 突破” 的循环,从早期符号逻辑的 “自上而下” 范式,到深度学习的 “自下而上” 数据驱动,再到大模型试图融合知识与统计的 “第三条道路”,每一次转折都伴随着方法论的革新。如今,我们站在 “通用人工智能(AGI)” 的门槛前,尽管距离人类水平智能仍有鸿沟,但大模型已掀开了 “机器辅助人类认知” 的新篇章。未来的关键挑战将集中于可解释性、常识推理、能源效率和伦理治理,这些议题不仅是技术问题,更需要跨学科的智慧与全球协作。

二、大模型

什么是大模型

大模型(Large Models) 是指通过海量数据训练、拥有庞大参数规模(通常预训练模型参数规模超十亿),并具备强大泛化能力和复杂任务处理能力的人工智能模型。其核心特点是通过深度学习架构(如 Transformer)和大规模预训练,实现对自然语言、图像、语音等多模态数据的理解与生成。

大模型与 AI 的关系

大模型属于人工智能中机器学习和深度学习的范畴,是机器学习技术的高阶形态,一种基于大规模数据和强大计算能力构建的复杂模型架构,通过学习海量的数据来捕捉数据中的模式和规律,从而实现对各种任务的处理和优化,如自然语言处理(NLP)、图像识别 (CV)、语音识别等,深度融合并推动 NLP、CV、机器人学等应用领域的发展。

大模型与传统 AI 的区别

表2

| 维度 | 大模型 | 传统 AI |

|---|---|---|

| 数据依赖 | 依赖海量通用数据(少样本或零样本) | 依赖特定任务标注数据 |

| 能力边界 | 跨领域泛化(文本、图像、代码等) | 单一任务(如图像分类) |

| 开发模式 | 预训练 + 提示词工程 | 工设计特征 + 模型调参 |

| 迭代方式 | 通用能力升级驱动多任务提升 | 逐个任务优化 |

大模型技术架构对比

表3

| 架构类型 | 代表模型/技术 | 核心优势 | 典型应用场景 |

|---|---|---|---|

| Transformer | GPT-4、ViT | 多任务通用性强 | 文本生成、图像分类 |

| MoE | DeepSeek-R1 | 高性价比推理 | 企业级服务、高频交易 |

| 扩散模型 | Stable Diffusion 3 | 高保真生成 | 艺术创作、影视特效 |

| 稀疏激活 | Mixture of Depths | 资源动态分配 | 边缘设备、长文本处理 |

| 多模态融合 | Gemini | 跨模态协同推理 | 智能客服、医疗影像 |

| 具身智能 | Tesla Optimus | 物理世界交互 | 机器人控制、自动驾驶 |

主流大模型产品对比分析

表4

| 模型名称 | 公司/机构 | 技术架构 | 模态支持 | 典型应用场景 | 幻觉控制策略 | 开源策略 | 参数量级 |

|---|---|---|---|---|---|---|---|

| ChatGPT | OpenAI | Transformer | 文本 → 多模态扩展 | 对话、代码生成 | RLHF + 自训练纠错 | 闭源 | 重量级(千亿) |

| DeepSeek | 深度求索 | MoE | 文本 | 对话、企业推理、数学问题解决、代码生成 | 知识验证器+置信度校准 | 全开源 | 中量级 |

| 文心一言 | 百度 | Transformer | 文本 | 问答、文本生成 | 知识图谱约束 + PPL 筛选 | 闭源 | 重量级 |

| 通义千问 | 阿里巴巴 | Transformer | 多模态 | 对话、电商客服、医疗问答 | 多模态对齐损失 + 对抗训练 | 闭源 | 重量级 |

| 混元 | 腾讯 | MoE + Transformer | 多模态 | 对话、复杂任务处理、3D 生成 | 知识蒸馏+多专家辩论框架 | 核心全开源+服务半开源+部分闭源 | 重量级 |

| Claude | Anthropic | 双模式架构 | 多模态 | 法律文本分析、科研文献 | 宪法 AI + 递归验证机制 | 闭源 | 重量级 |

| Kimi | 月之暗面 | 分离式推理架构 | 文本 | 文档分析、知识库构建 | 长上下文注意力缓存压缩 | 闭源 | 中量级 |

| Gemini | 原生多模态架构 | 多模态 | 对话、医疗影像诊断、跨媒体生成 | 跨模态一致性验证 | 闭源 | 重量级 | |

| 豆包 | 字节跳动 | 稀疏 MoE | 多模态 | 对话、语音交互、智能家居 | 语音-文本联合推理阈值过滤 | 半开源 | 中量级 |

| Grok | xAI (Elon Musk) | 混合架构 | 文本 | 实时数据分析、专业领域问答 | 实时知识检索 + 概率截断 | 闭源 → 计划开源 | 重量级 |

| LLaMA | Meta (原 Facebook) | Transformer | 文本 | 学术研究、低成本开发 | 采样后处理(Nucleus Sampling) | 全开源 | 轻量级-中量级 |

| 讯飞星火 | 科大讯飞 | 1+N 架构 | 文本 → 多模态扩展 | 教育辅导、医疗咨询 | 领域知识图谱辅助 | 闭源 | 中量级 |

| 智普 AI(GLM) | 智谱 AI(清华系) | GLM 架构 | 文本 | 工业质检、代码辅助 | 分层解码约束 + 语义相似度检测 | 半开源 | 重量级 |

| 百川智能 | 百川智能(王小川) | 轻量级蒸馏 | 文本 | 金融风控、医疗咨询 | 轻量级模型蒸馏优化 | 半开源 | 轻量级 |

大模型发展历程

AI 大模型技术出现于 2017 年左右,其发展历程如下:

1. 技术基础与早期探索(1950s - 2016 年):

- 1956 年人工智能概念诞生。

- 1957 年感知机出现,为早期神经网络雏形。

- 1974 年反向传播算法被提出,为神经网络优化提供理论支持。

- 1993 年深度学习理论基础开始形成。

- 2012 年 AlexNet 在图像识别竞赛中获胜,推动深度学习发展。

- 2014 年 Seq2Seq 模型和注意力机制被提出,促进自然语言处理领域发展。这一阶段神经网络基础理论得到发展,但模型规模较小,参数在百万级。

2. 大模型发展期(2017 年 - 至今):

- 2017 年:Transformer 架构诞生,引入自注意力机制,解决长程依赖问题,奠定了大模型技术基础。

- 2018 年:BERT 和 GPT-1 分别发布,标志着预训练模型时代的正式开启。

- 2019 年:OpenAI 发布 GPT-2,参数规模达到 15 亿,生成式模型潜力被广泛认可。

- 2020 年:GPT-3 发布,参数规模达到 1750 亿,成为当时最大的语言模型,在零样本学习任务上有巨大性能提升。

- 2022 年:ChatGPT 发布,基于 GPT-3.5 架构的对话模型迅速引爆全球,用户数突破 1 亿仅用 2 个月,推动 AI 从“工具”向“助手”转变。

- 2023 年:多模态大模型如 GPT-4V、Gemini Pro 等相继推出,AI 进入全新发展阶段,大模型支持的模态更加多样,从单一模态下的单一任务,逐渐发展为支持多种模态下的多种任务。

- 2025 年:DeepSeek R1 发布,采用 MoE 架构,训练成本仅为 GPT-4 的 1/70,推理成本降低至 1/30,用户数突破 1 亿仅用了 7 天,推动 AI 大规模商用。

大模型发展方向

1. 模型轻量化

通过知识蒸馏(如 TinyBERT)、量化压缩(8bit 训练)等技术,减少模型参数和计算量,提高模型运行效率,使其能在资源受限的设备上运行。

2. 多模态融合

实现文本、图像、视频、3D 模型等多模态数据的统一表征学习,让模型能更全面地理解和处理复杂信息,更贴近人类的多模态交互方式,拓展人工智能的应用场景。

3. 具身智能

将大模型与机器人等实体系统相结合,如 Tesla Optimus 机器人结合大模型实现环境交互与决策,使智能体能够在真实世界中感知、行动和学习,完成各种复杂任务。

4. 生物计算

探索 DNA 存储技术与类脑计算架构的融合,借鉴生物大脑的信息处理机制,为大模型的发展提供新的思路和架构,可能带来计算能力和能效方面的突破。

三、大语言模型

什么是大语言模型

大语言模型(LLM):基于海量文本数据训练的深度学习模型(如 GPT、LLaMA、BLOOM),学习语言规律、语义关联和世界知识,通过 Transformer 架构实现上下文理解与生成,核心能力包括语义建模、知识推理和长文本处理。

其他相关概念:

- 预训练(Pre-training):在通用数据上训练模型基础能力。

- 微调(Fine-tuning):针对特定任务(如翻译、问答)优化模型参数。

- 提示工程(Prompt Engineering):通过设计输入指令提升模型输出质量。

大语言模型的核心能力

1. 自然语言理解(NLU)

- 解析语法结构、语义角色(如 “谁对谁做了什么”)。

- 识别情感倾向(如评论中的正面 / 负面情绪)、实体关系(如 “爱因斯坦 — 科学家”)。

2. 自然语言生成(NLG)

- 创作连贯文本:小说、新闻、代码、邮件等。

- 多风格生成:模仿特定语气(如正式公文、幽默段子)。

3. 推理与问题解决

- 常识推理:回答 “为什么冬天会下雪” 等日常问题。

- 逻辑推理:解决数学题(如 GPT-4 通过 GRE 数学部分测试)、编程调试(如 GitHub Copilot)。

4. 对话交互

- 上下文记忆:支持多轮对话(如 ChatGPT 支持数百轮历史对话)。

- 角色模拟:扮演医生、教师、虚拟助手等特定角色。

大语言模型与大模型的关系

大语言模型(LLM)是大模型(LM)的一个重要分支,是以自然语言(文本)为核心处理对象的超大规模人工智能模型。掌握 LLMs 是理解大模型生态的基石,后续可向多模态、具身智能等方向延伸。

大语言模型与大模型关键技术差异

表5

| 维度 | 大语言模型 | 大模型 |

|---|---|---|

| 架构基础 | 纯 Transformer 架构为主 | Transformer/CNN/MoE 混合 |

| 训练数据 | 纯文本语料库(如 Common Crawl) | 多模态数据集(文本+图像+传感器数据) |

| 输出形式 | 文本/代码 | 跨模态内容(如文生视频) |

| 典型任务 | 机器翻译、情感分析 | 自动驾驶路径规划、蛋白质结构预测 |

如何掌握大语言模型:从工具使用者到价值创造者

- 掌握大语言模型:理解 Transformer 架构、注意力机制、Prompt 工程。

- 掌握大语言模型的关键在于:先理解其 “能做什么” 和 “不能做什么”,再聚焦具体场景设计解决方案。对于非技术背景者,可从提示工程和 API 调用切入,快速实现效率提升;技术人员则可深入模型微调与底层优化,探索行业专属应用。

- 理性看待模型能力:LLM 擅长模式匹配而非真正理解,复杂逻辑推理、高风险、强专业性、伦理敏感或需要深度人类判断的领域,仍需人类介入,避免过度依赖导致决策失误。

- 最终,大语言模型的价值不在于 “替代人类”,而在于作为倍增器,放大个体与组织的创造力。持续学习、结合领域知识、保持理性批判思维,才能在这场技术变革中占据主动。

附

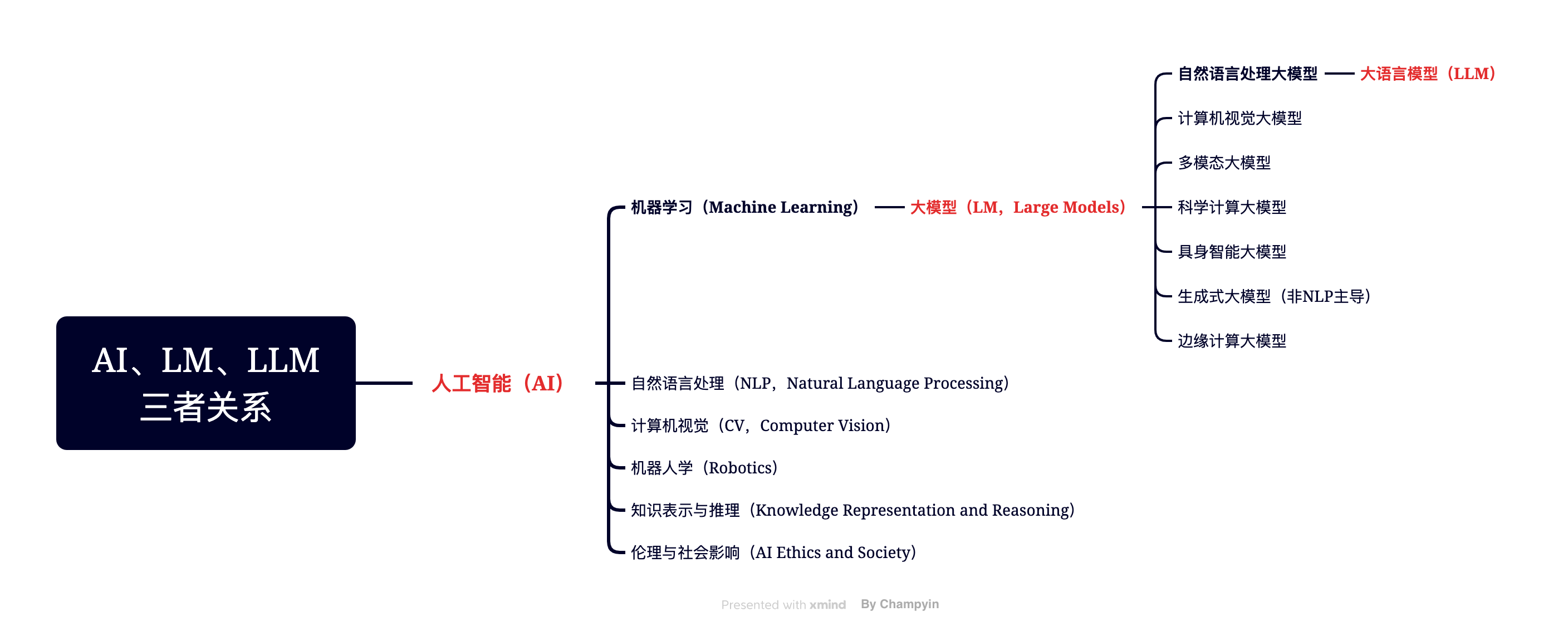

一张图表示人工智能、大模型、大语言模型之间的关系

推荐论文:

[1] Ashish Vaswani, Noam Shazeer, Niki Parmar, Jakob Uszkoreit, Llion Jones, Aidan N. Gomez, Lukasz Kaiser, and Illia Polosukhin. Attention Is All You Need. arXiv preprint arXiv:1706.03762, 2017.

[2] Jason Wei, Xuezhi Wang, Dale Schuurmans, Maarten Bosma, Brian Ichter, Fei Xia, Ed Chi, Quoc Le, and Denny Zhou. Chain-of-Thought Prompting Elicits Reasoning in Large Language Models. arXiv preprint arXiv:2201.11903, 2022.

[3] Yue Zhang, Yafu Li, Leyang Cui, Deng Cai, Lemao Liu, Tingchen Fu, Xinting Huang, Enbo Zhao, Yu Zhang, Yulong Chen, Longyue Wang, Anh Tuan Luu, Wei Bi, Freda Shi, and Shuming Shi. Siren’s Song in the AI Ocean- A Survey on Hallucination in Large Language Models. arXiv preprint arXiv:2309.01219, 2023.

文章同时发表于公众号「前端手札」,喜欢的话可以关注一下哦。